コミュニケーションとインタラクション

これまで、音楽を聴いて,適応的に人とインタラクションを行うロボット,自分自身が作り出す自己動作雑音を抑圧しながら,周囲の音環境を聞き分けることができるロボット,ロボット自身が話している間にユーザから話しかけられても会話を続けることができるロボットなど,ロボット聴覚技術適用した人・ロボットコミュニケーションへ応用していく研究を行ってきましたが,2021年4月の講座名変更を機に,コミュニケーションやインタラクションへの将来的な適用を念頭した新しい研究テーマをこれまでの技術を発展させる形で取り組んでいます。

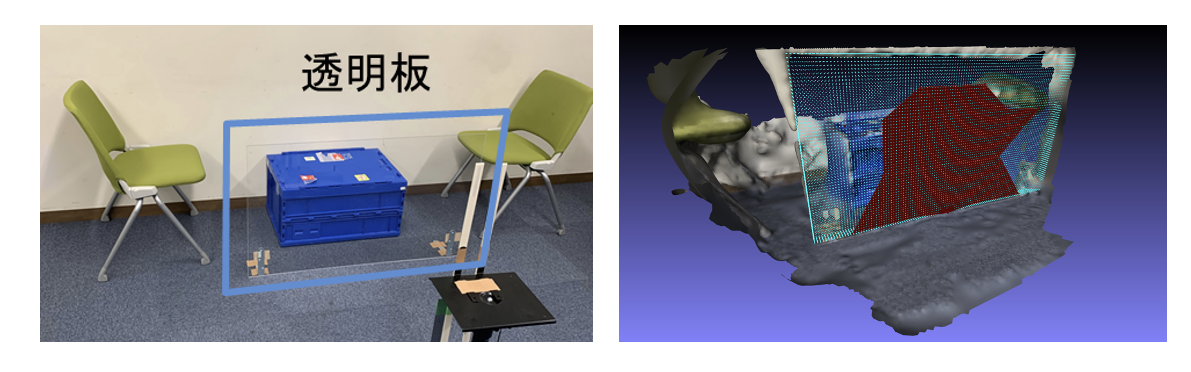

具体的には,「気配を察知」したり,「空気を読む」ことができる技術の構築を目指します。このために複数の情報を統合したり,単独の情報では補いきれない部分を他の情報でカバーするマルチモーダル認識・予測技術を扱っていきます

こうした技術が構築できれば,人との親和性が高く,場をわきまえたシステムの実現につながると考えています。

研究室のテーマの中では新しいテーマです.現在はその第一歩として,様々な振動の観測が含まれる1拠点の振動計データから,地震のみを検出し,大きさを認識する研究や,音から周囲の環境を把握する研究,視聴覚環境認識研究など,気配の察知につながるセンシング技術の研究を行っています。

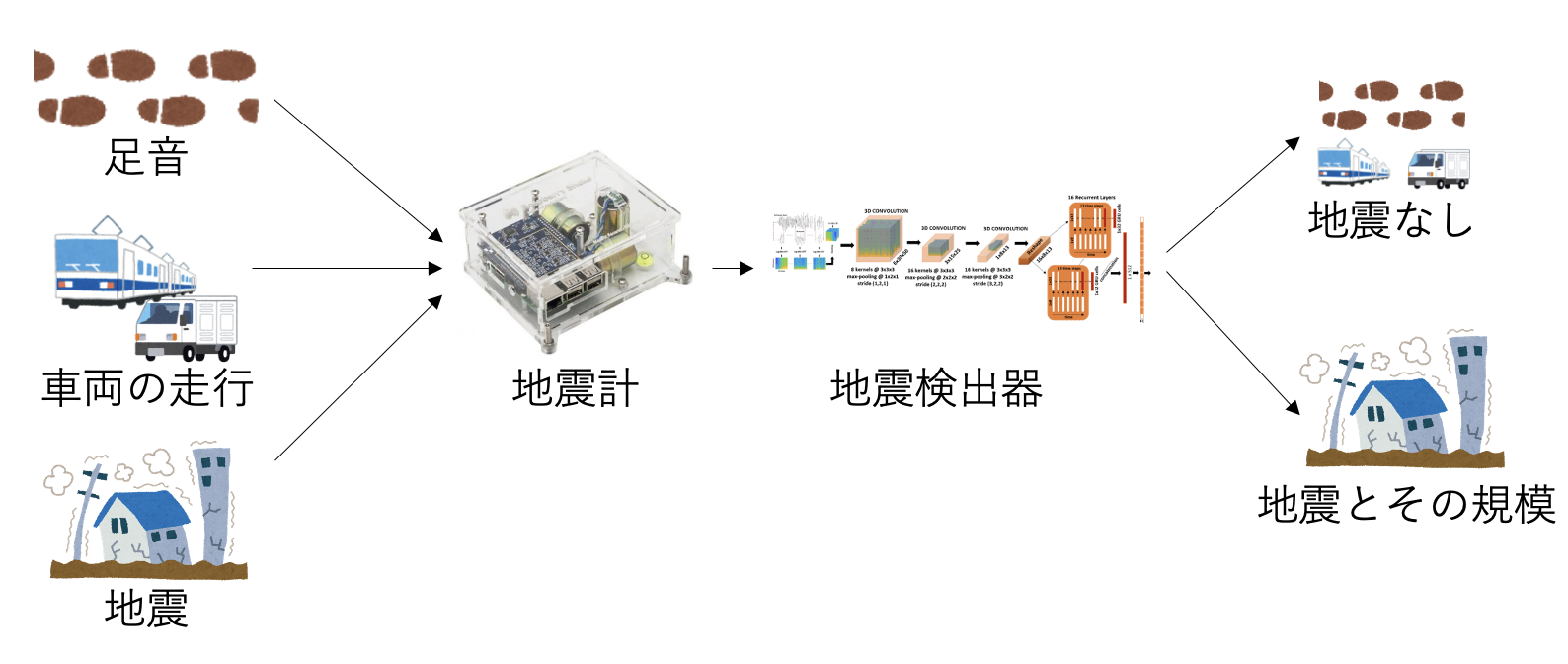

拠点振動計データからの地震検出・強度識別

地震以外の振動の観測が少ない複数の場所のデータから,地震の検出とその大きさの判定を行っていたが,深層学習技術を用いることで,都心など様々な振動が計測される1拠点の振動計のデータを使っても,ある程度の地震の検出が可能であることを示した.

可聴音信号によるマップ生成

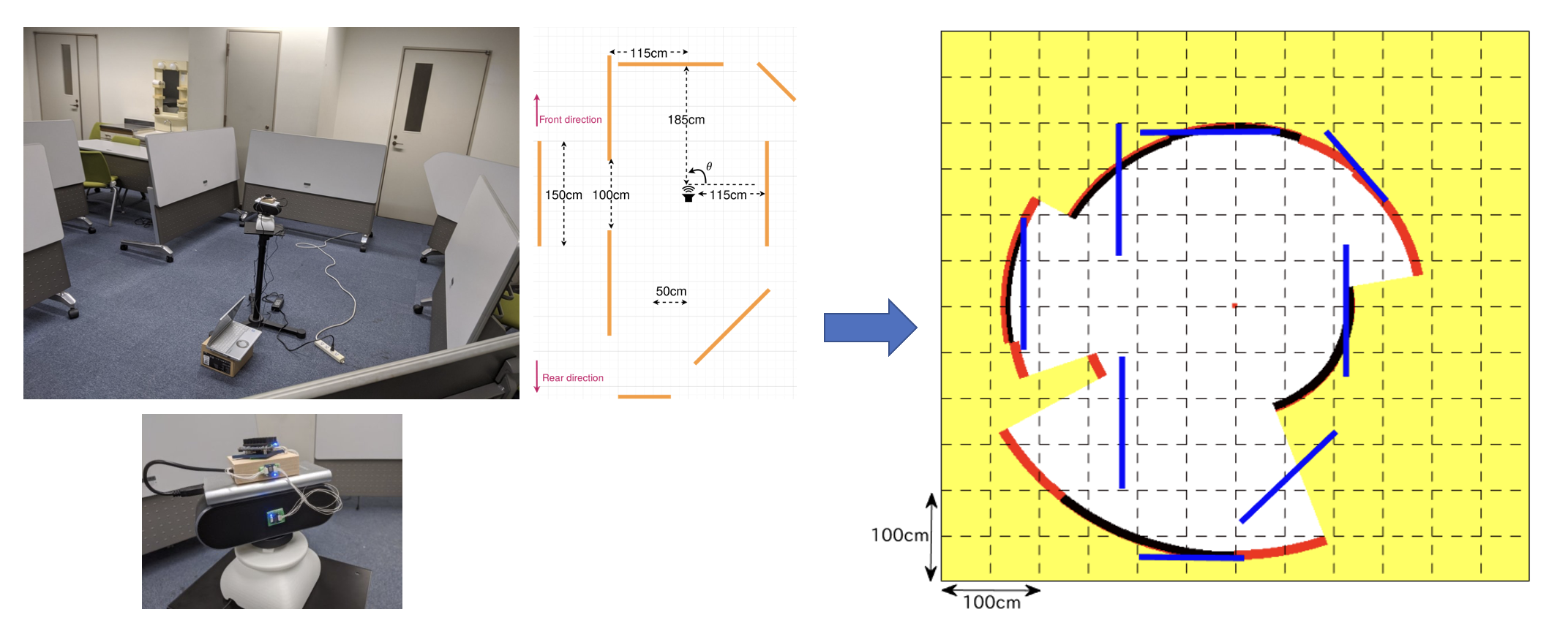

音響計測では,超音波が用いられることが多いが,定在波法と重み付き尤度関数法という複数の手法を統合することで可聴音でも周囲の環境を計測できる手法を構築している。

耳から得られる情報のみから周囲の環境を認識できる能力(エコーロケーション)が知られており,視覚障がい者の中にはこうした能力を訓練して壁や障害物の検出を行うことができる人もいる。こうした技術の構築を目指して,可聴音を用いた地図生成の研究を行っている。

視聴覚環境認識

音、もしくは画像のどちらかだけを使って,周囲の環境を完全に理解することは困難です。そのような欠落した情報やあいまいな情報を別のモダリティから補完する研究を行っています

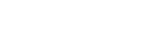

図1は、SfMは静的なシーンのみを想定しているという強い仮定を緩和するため視聴覚統合を用いた、動的な動きを伴うシーンの4D再構成の例です。

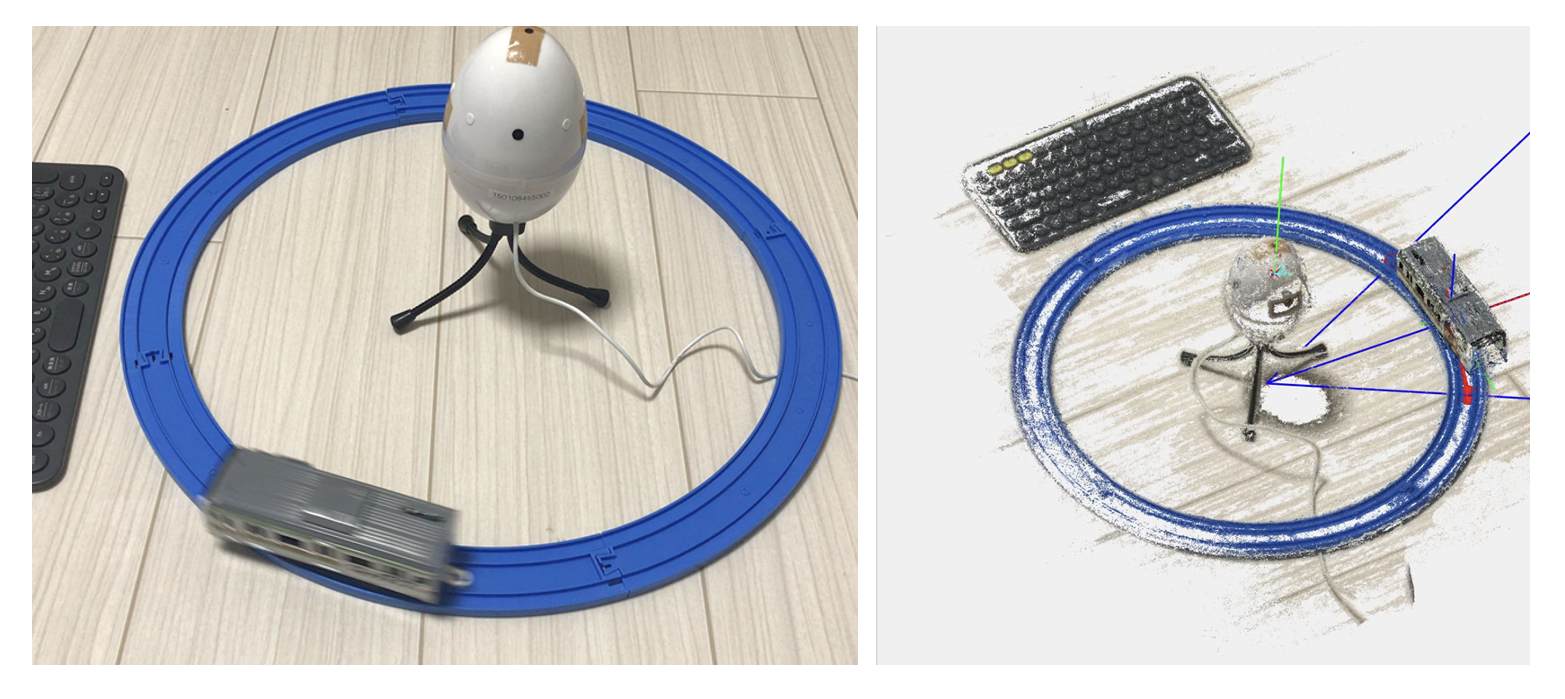

図2は、視覚情報だけでは再構築できない透明なオブジェクトの再構築を示しています。